用 Markdown 分割线提升 AI 技术文档的结构清晰度

在深度学习项目开发中,一个常见的痛点是:新成员加入团队后,花两三天才配好环境;模型能跑通却无法复现,只因为某人本地装了不同版本的 NumPy;更别说多人协作时,“在我机器上没问题”成了甩锅金句。这些看似琐碎的问题,背后其实是两个核心挑战——环境一致性和知识传递效率。

而现代 AI 工程实践早已给出答案:容器化解决运行时问题,结构化写作保障信息准确传达。今天我们就以TensorFlow-v2.9容器镜像为例,看看如何通过一个看似微不足道的工具——Markdown 中的分割线(---),来显著提升技术文档的专业性与可读性。

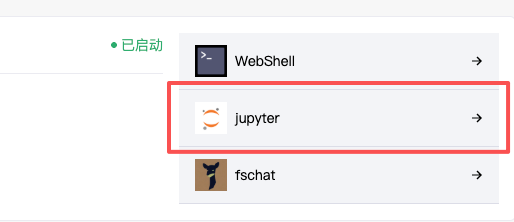

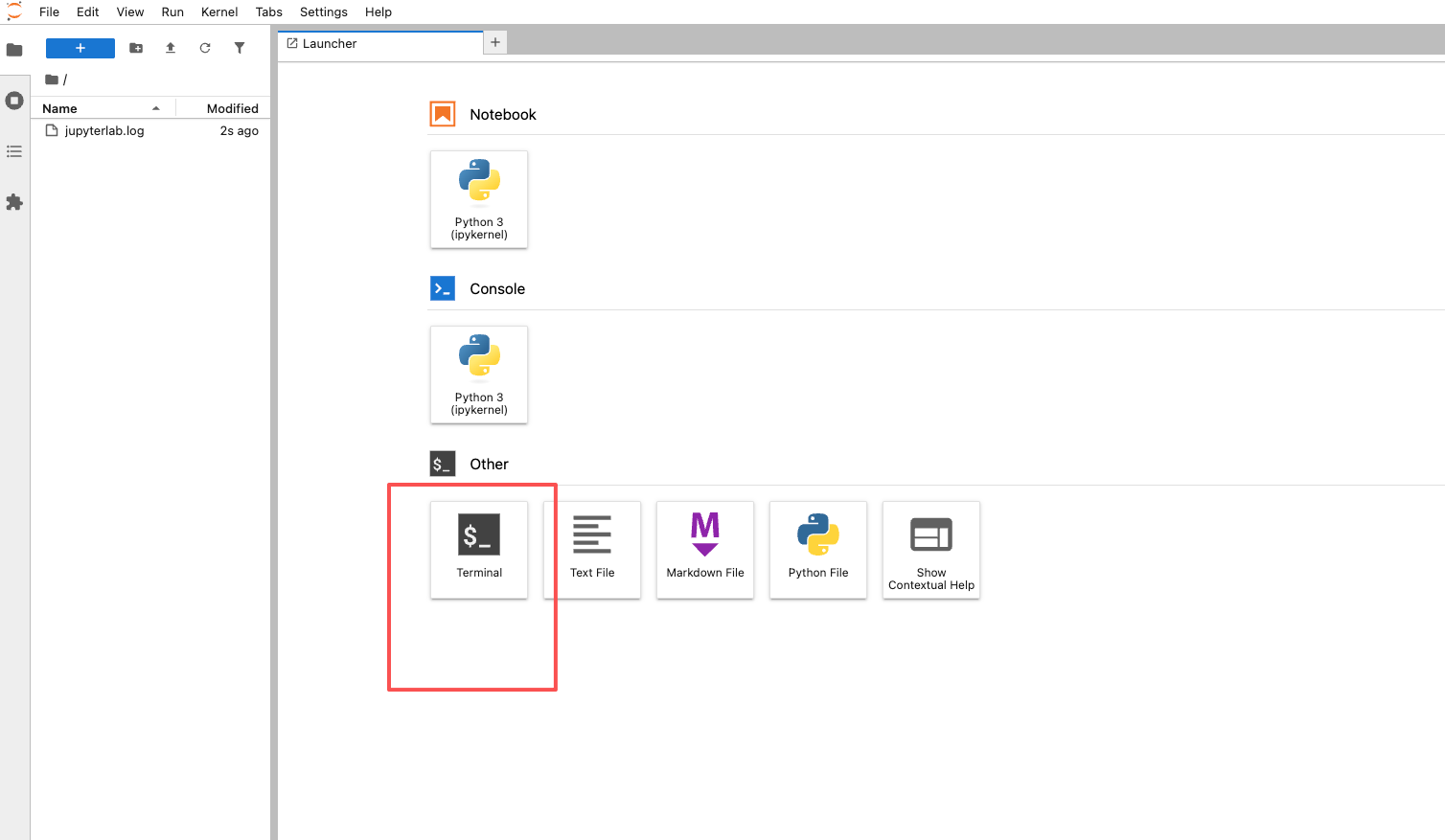

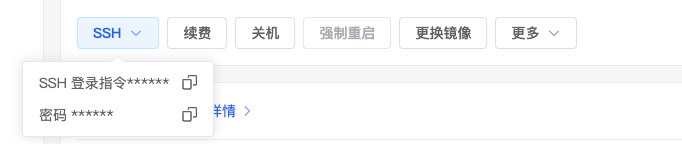

先来看这个场景:你接手了一份项目文档,里面写着“可以通过 Jupyter 或 SSH 使用该镜像”。接下来是一堆命令、截图和说明,但没有明显分隔。你是继续往下读,还是得自己判断哪里讲完了一个功能?如果我把这两个模块用一条---隔开呢?

## Jupyter 的使用方式   --- ## SSH 的使用方式  是不是立刻就清楚了:这是两种独立的操作路径?这种视觉上的“呼吸感”,正是---带来的最直接价值。

这不仅仅是个排版技巧。当我们深入到 TensorFlow-v2.9 这个镜像的设计逻辑时会发现,它的架构本身就体现了“分离关注点”的思想——既支持图形界面交互调试,也允许命令行自动化控制。那么文档自然也应该反映出这种并列关系,而不是让读者去猜。

镜像不是简单的打包,而是开发范式的封装

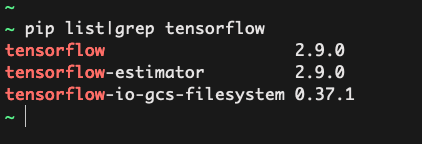

TensorFlow-v2.9镜像本质上是一个预配置的 Docker 容器镜像,集成了 Python 环境、TensorFlow 框架、Keras、Jupyter Notebook、TensorBoard,甚至 CUDA 驱动支持(如果是 GPU 版本)。它不是把一堆东西塞进一个包里那么简单,而是在尝试定义一种标准开发体验。

比如它的构建流程通常是这样的:

- 基础系统层:基于 Ubuntu 或 Debian;

- 依赖安装层:Python + pip + 科学计算库(NumPy/Pandas)+ CUDA/cuDNN(GPU 支持);

- 框架集成层:

pip install tensorflow==2.9.*,锁定版本避免 API 变更带来的兼容性问题; - 服务注入层:预设启动脚本,自动运行 Jupyter 或 SSH 服务。

每一层都可缓存、可复用,最终形成一个轻量、一致且可迁移的运行环境。当你拉取一次镜像后,无论是在 Mac 上做原型设计,还是在 Linux 服务器上训练模型,行为完全一致。

这也意味着,一旦环境出了问题,排查范围大大缩小——不再是“谁装错了什么”,而是聚焦于配置或数据本身。

为什么传统文档容易失效?

我们再回头想想那些让人头疼的技术手册:

- 没有明确边界,所有内容堆在一起;

- 步骤跳跃,缺少上下文衔接;

- 图片与文字脱节,看完还不知道下一步在哪。

这些问题的根本原因,是写作者默认“读者知道我想表达什么”,忽略了信息接收端的认知负荷。

而像---这样的简单语法,其实是在强制建立一种写作纪律:每当你想加一条分割线时,就得问自己一句:“前面的内容是否已经完整?接下来是不是要切换主题?” 这种自我审查机制,本身就是高质量文档的起点。

来看一段典型的应用示例:

# 拉取镜像 docker pull registry.example.com/tensorflow:2.9-gpu-jupyter # 启动容器,映射端口并挂载工作目录 docker run -d \ --name tf-dev \ -p 8888:8888 \ -p 2222:22 \ -v ./notebooks:/workspace/notebooks \ registry.example.com/tensorflow:2.9-gpu-jupyter # 查看日志获取 Jupyter 访问令牌 docker logs tf-dev这段代码本身很清晰,但如果文档紧接着又说“也可以用 Conda 创建环境”,就会造成混淆。正确的做法是,在介绍完 Docker 方案后,用---明确划分出另一个章节,比如 “替代方案:Conda 虚拟环境”,告诉读者:“现在我们要换一种思路了。”

结构即意义:从视觉节奏到认知引导

很多人以为 Markdown 只是为了“好看”,其实不然。好的结构设计,本质上是一种认知工程。

考虑以下三种分段方式:

| 方法 | 效果 |

|---|---|

| 空白行 | 轻微停顿,适合段落内换行 |

| 多级标题 | 强调层级,但可能显得冗长 |

---分割线 | 视觉中断,暗示主题转换 |

当你在写一份部署指南时,可能会包含如下部分:

- 环境准备

- 镜像拉取

- 容器启动

- 访问方式(Jupyter / SSH)

- 数据持久化

- 故障排查

其中,“访问方式”下面有两个平行子项。如果只用三级标题,容易让整体结构变得扁平;如果不用任何分隔,则可能导致用户误以为 SSH 是 Jupyter 的后续步骤。

此时,---就成了最佳选择——它不增加语义层级,却清晰地标示出“这是两个独立选项”。

而且,几乎所有主流平台都完美支持这一语法:GitHub、GitLab、VS Code、Typora、Obsidian、Notion(部分)、博客系统等。你在本地写的.md文件,发布出去几乎不会走样。

实际应用场景中的设计权衡

当然,也不能滥用。我在审阅团队文档时,常看到有人每隔两三段就加一条---,结果页面像被切碎了一样。这就违背了初衷。

以下是几个实用建议:

- ✅在功能模块之间使用:如“Jupyter 使用”与“SSH 使用”、“训练流程”与“推理部署”;

- ✅配合二级或三级标题使用:保持视觉平衡,避免喧宾夺主;

- ✅用于区分操作模式:例如交互式开发 vs 批处理任务;

- ❌不要用于段落内部换行:那是空行的工作;

- ❌不要连续使用多条:如

---\n---\n---,毫无意义; - ❌不要代替列表或表格:复杂对比应使用更结构化的形式。

还有一个细节值得提:在支持 CSS 的环境中(比如自建 Wiki 或博客),你可以定制hr样式,让它更符合品牌风格:

hr { border: 1px solid #e0e0e0; margin: 2em 0; opacity: 0.6; }这样既保留了语义清晰性,又提升了阅读舒适度。

文档也是产品的一部分

最后想强调一点:技术文档不是附属品,而是产品的延伸。

一个再强大的 AI 模型,如果别人看不懂怎么用,等于不存在。反过来,一份结构清晰、图文并茂、逻辑分明的文档,能让普通开发者快速上手,甚至激发二次创新。

当我们在推广TensorFlow-v2.9镜像这类工具时,不能只说“它预装了所有依赖”,更要展示“如何高效地教会别人使用它”。而 Markdown 的---,正是实现这一目标的最小可行单元。

它不需要学习成本,不依赖特定工具链,却能在无形中提升整篇文档的信息密度与传达效率。就像容器镜像统一了运行环境一样,合理的结构规范也在统一团队的知识表达方式。

所以下次当你写技术文档时,不妨多问一句:这里要不要加一条---?也许就是这一笔,让读者少花了十分钟理解成本。